LFighter: Defensa contra ataques en el aprendizaje automático federado

- 18 April 2024

- Publicaciones científicas

LFighter: Defensa contra ataques en el aprendizaje automático federado

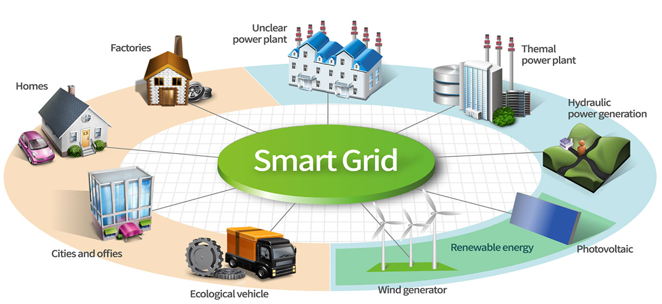

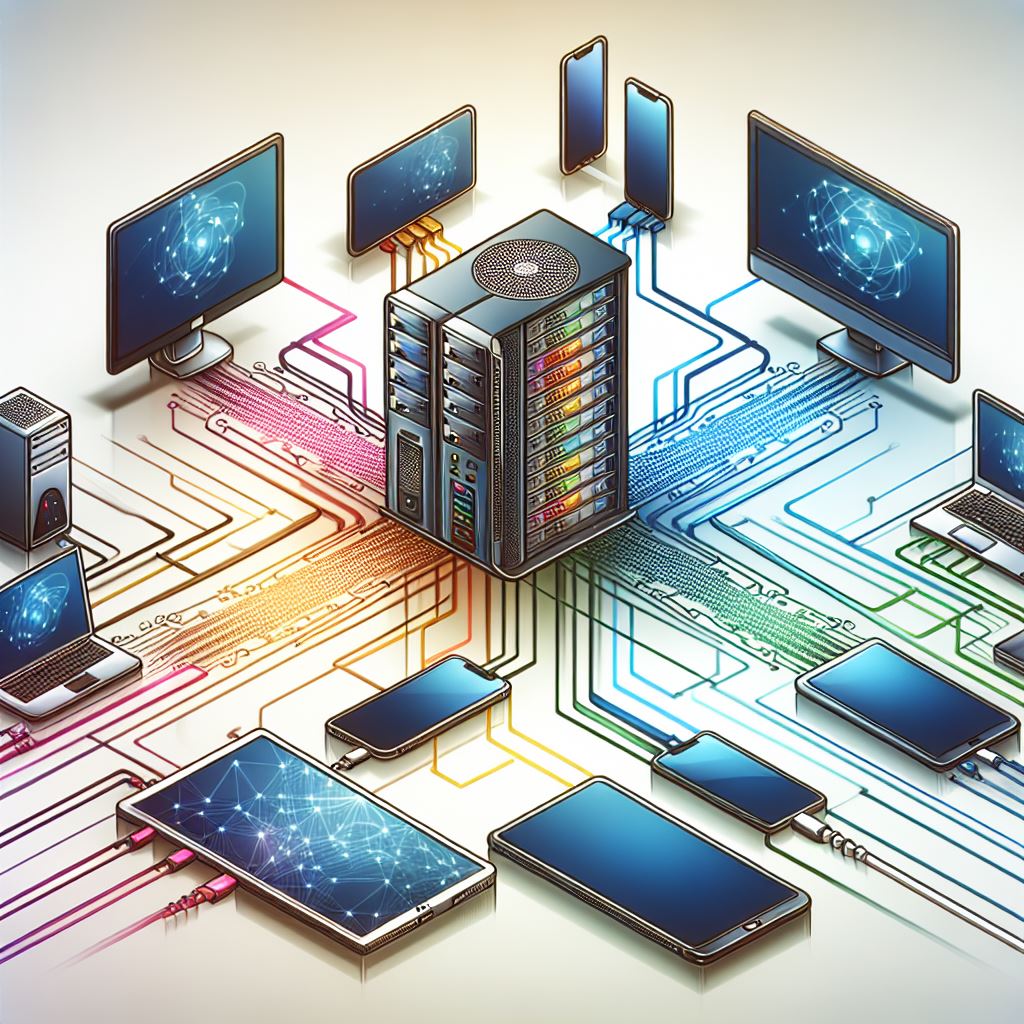

El Aprendizaje Automático (ML, por sus siglas en inglés) es una rama de la Inteligencia Artificial y la Ciencia de la Computación que se enfoca en el uso de algoritmos y datos para identificar patrones ocultos con el fin de realizar predicciones. ML generalmente considera arquitecturas centralizadas, donde los datos de los usuarios se comparten con una entidad central. Esto puede resultar en vulneraciones a la privacidad, especialmente cuando se trata de datos sensibles. El Aprendizaje Federado (FL, por sus siglas en inglés) es un paradigma de ML centrado en abordar este problema, entre otros, sirviendo como una solución para la autonomía y la privacidad de los datos mientras aún se mantiene la colaboración en la modelización para el aprendizaje automático. Sin embargo, esta descentralización introduce vulnerabilidades que pueden ser explotadas por actores maliciosos a través de ataques de envenenamiento dirigidos, como lo puede ser el ataque de cambio de etiqueta (LF, por sus siglas en inglés). Los atacantes de LF subvierten los datos de entrenamiento cambiando las etiquetas de una clase a otra, por ejemplo, ejemplos correctos de actividades “fraudulentas” se modifican a “no fraudulentas”, afectando el rendimiento del modelo global.

LFighter se presenta como una defensa novedosa contra los ataques de LF, basada en la observación de que los objetivos contradictorios entre los atacantes y los ‘peers’ honestos pueden convertir los gradientes de parámetros conectados a la clase fuente y objetivo en una característica discriminatoria que permite la detección de posibles actualizaciones maliciosas. LFighter identifica y extrae gradientes relevantes de las actualizaciones locales de los ‘peers’, agrupándolos en dos clases y analizando posteriormente los clústeres resultantes para filtrar posibles actualizaciones malas, todo antes de la agregación del modelo FL.

Evaluaciones empíricas exhaustivas en diversos conjuntos de datos subrayan la eficacia de LFighter, demostrando mejoras sobre otras defensas propuestas que requieren suposiciones previas como la distribución de datos y la dimensionalidad del modelo, al mismo tiempo que supera a las defensas existentes en la reducción del error de prueba, la precisión general y la precisión de la clase fuente.

Referencia: